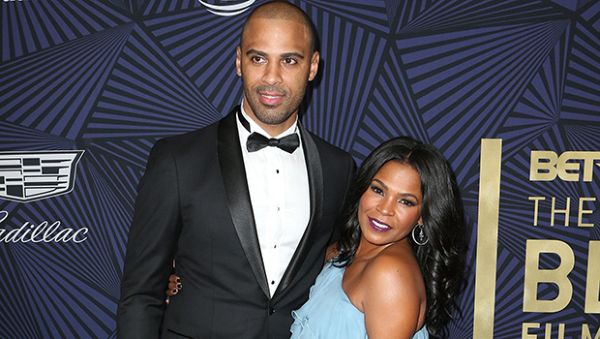

Stephen Hawking, Elon Musk y Bill Gates. (Foto: Getty Images)

Stephen Hawking, Elon Musk y Bill Gates. (Foto: Getty Images) Algunas de las películas de ciencia ficción más populares: 2001: Una odisea del espacio, Terminator, Matrix, Trascendencia, Ex Machina y muchos otros, se han basado en la noción de que la inteligencia artificial evolucionará hasta un punto en el que la humanidad no podrá controlar sus propias creaciones, lo que conducirá a la desaparición de toda nuestra civilización. Este temor al rápido crecimiento de la tecnología y nuestra creciente dependencia de ella ciertamente está justificado, dadas las capacidades de las máquinas actuales construidas para fines militares.

La tecnología ya ha tenido un impacto significativo en la guerra desde que comenzó la guerra de Irak en 2001. Los drones no tripulados brindan vigilancia sostenida y ataques rápidos a objetivos, y se utilizan pequeños robots para desarmar artefactos explosivos improvisados. El ejército está actualmente fondos investigación para producir más robots autónomos y autoconscientes para disminuir la necesidad de que los soldados humanos arriesguen sus vidas. El fundador de Boston Dynamics, Marc Raiber, lanzó un video que muestra un aterrador de seis pies de alto y 320 libras. robot humanoide llamado Atlas, corriendo libremente por el bosque. La empresa, que fue comprado por Google en 2013 y recibe una subvención del Departamento de Defensa, está trabajando en el desarrollo de una versión aún más ágil.

[protected-iframe id = f3ad9cb5d88743d09a7e6c45b1a9b09b-35584880-78363900 ″ info = https: //www.youtube.com/embed/NwrjAa1SgjQ width = 560 ″ height = 315 ″ frameborder = 0 ″ allowfullscreen =]

Los peligros inherentes de una tecnología tan poderosa han inspirado a varios líderes de la comunidad científica a expresar sus preocupaciones sobre la Inteligencia Artificial.

El éxito en la creación de IA sería el evento más grande en la historia de la humanidad, escribió Stephen Hawking en un artículo de opinión, que apareció en El independiente en 2014. Desafortunadamente, también podría ser el último, a menos que aprendamos a evitar los riesgos. A corto plazo, los ejércitos mundiales están considerando sistemas de armas autónomos que pueden elegir y eliminar objetivos. El profesor Hawking agregó en un 2014 entrevista con BBC , los humanos, limitados por la lenta evolución biológica, no podrían competir y serían reemplazados por A.I.

La tecnología descrita por Hawking ya ha comenzado en varias formas, que van desde científicos estadounidenses usando computadoras para ingresar algoritmos predecir las estrategias militares de los extremistas islámicos a empresas como Boston Dynamics que han construido robots móviles con éxito , mejorando constantemente cada prototipo que crean.

Hawking se unió recientemente a Elon Musk, Steve Wozniak y cientos de personas más para emitir una carta presentada en la Conferencia Conjunta Internacional el mes pasado en Buenos Aires, Argentina. La carta advierte que la inteligencia artificial puede ser potencialmente más peligrosa que las armas nucleares.

El dilema ético de otorgar responsabilidades morales a los robots exige medidas rigurosas de seguridad y prevención que sean a prueba de fallas, o las amenazas son demasiado importantes para arriesgar.

Elon Musk calificó la perspectiva de la inteligencia artificial como nuestra mayor amenaza existencial en 2014 entrevista con estudiantes del MIT en el Simposio AeroAstro Centennial. Me inclino cada vez más a pensar que debería haber alguna supervisión regulatoria, tal vez a nivel nacional e internacional, solo para asegurarme de que no hacemos algo muy tonto. Musk cita su decisión de invertir en la firma de Inteligencia Artificial, DeepMind, como una medio para estar atento a lo que sucede con la inteligencia artificial. Creo que ahí hay un resultado potencialmente peligroso.

El cofundador de Microsoft, Bill Gates, también ha expresado su preocupación por la inteligencia artificial. Durante una sesión de preguntas y respuestas en Reddit en enero de 2015, dijo el Sr. Gates, estoy en el campo que está preocupado por la superinteligencia. Primero, las máquinas harán muchos trabajos por nosotros y no serán súper inteligentes. Eso debería ser positivo si lo gestionamos bien. Unas décadas después de eso, aunque la inteligencia es lo suficientemente fuerte como para ser una preocupación. Estoy de acuerdo con Elon Musk y algunos otros en esto y no entiendo por qué algunas personas no están preocupadas.

Las amenazas enumeradas por Hawking, Musk y Gates son reales y merecen nuestra atención inmediata, a pesar de los inmensos beneficios que la inteligencia artificial puede traer potencialmente a la humanidad. A medida que la tecnología de los robots aumenta constantemente hacia los avances necesarios para facilitar la implementación generalizada, se hace evidente que los robots se encontrarán en situaciones que plantean una serie de cursos de acción. El dilema ético de otorgar responsabilidades morales a los robots exige medidas rigurosas de seguridad y prevención que sean a prueba de fallas, o las amenazas son demasiado importantes para arriesgar.